Wyzwania młodych w rekrutacji – fałszywe ogłoszenia i sztuczna inteligencja

Artykuł bazuje na doświadczeniach zebranych w ramach inicjatywy SAGE – Social and Green Entrepreneurship network for youth.

WPROWADZENIE

Ten artykuł analizuje dwie kluczowe bariery, z którymi młode osoby mierzą się na starcie kariery: fałszywe ogłoszenia o pracę oraz algorytmy AI w rekrutacji. Tekst bazuje na doświadczeniach zebranych w ramach inicjatywy SAGE – Social and Green Entrepreneurship network for youth.

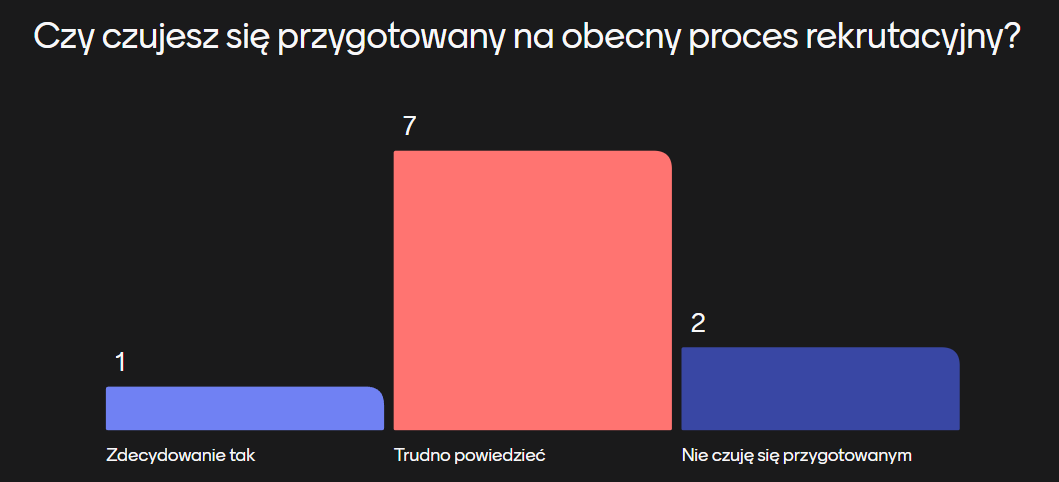

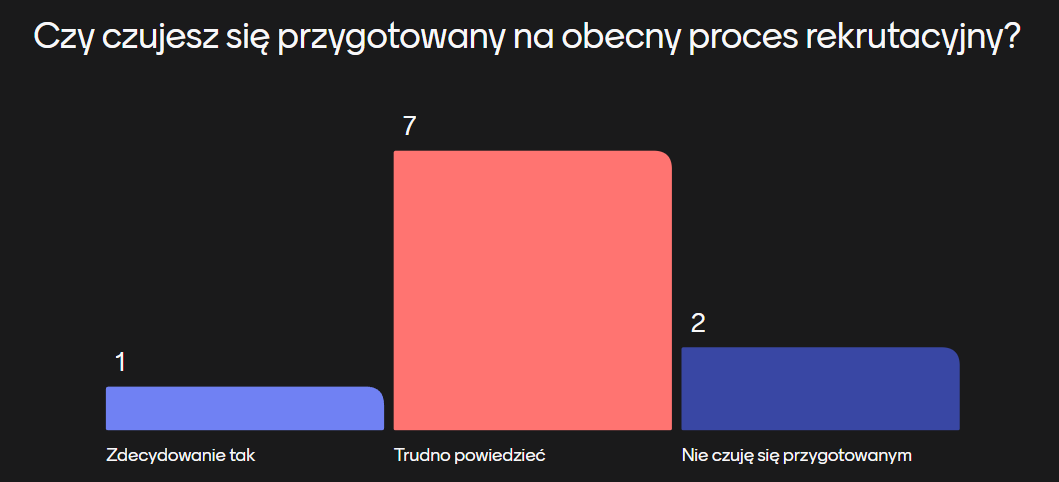

W SAGE przeprowadziliśmy krótkie, interaktywne warsztaty z 10 młodymi osobami. Spotkanie miało formę otwartej dyskusji: uczestnicy dzielili się konkretnymi historiami z rynku pracy i wspólnie mapowali najtrudniejsze momenty procesu rekrutacyjnego. Najczęściej powtarzały się wątki: brak doświadczenia przy wysokich wymaganiach pracodawców, bariery finansowe, bariery językowe i kulturowe (szczególnie u osób z doświadczeniem migracyjnym) oraz brak praktycznej edukacji o rynku pracy.

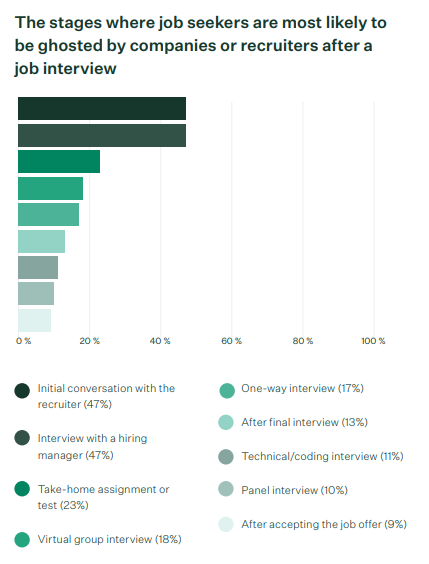

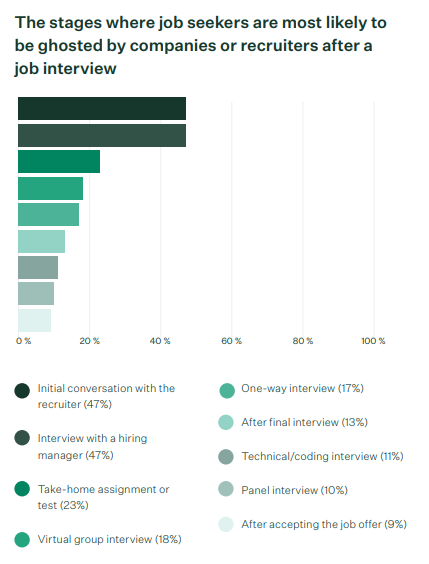

Najmocniejszym wspólnym mianownikiem okazał się moment „utknięcia” już po wysłaniu aplikacji: wielu uczestników nie otrzymuje żadnej odpowiedzi od pracodawców. Ta cisza generuje frustrację, poczucie braku sprawczości i demotywację, skutecznie hamując dalsze kroki w poszukiwaniu pracy. To doświadczenie stanowi punkt wyjścia do dalszej analizy: skąd biorą się fałszywe ogłoszenia i jaką rolę w procesie selekcji odgrywa sztuczna inteligencja.

FAŁSZYWE OGŁOSZENIA O PRACĘ – UKRYTA PUŁAPKA RYNKU

Skala fałszywych ogłoszeń

„Ghost jobs” – czyli ogłoszenia publikowane bez realnej intencji zatrudnienia – przestały być marginesem. Dane operacyjne z platformy rekrutacyjnej Greenhouse pokazują, że w każdym kwartale 18–22% wszystkich ofert na ich systemie kwalifikuje się jako ogłoszenia-widma.

Z kolei badania deklaratywne odsłaniają skalę praktyki po stronie pracodawców i rekruterów: w ankiecie ResumeBuilder ok. 40% firm przyznało, że w ostatnim roku opublikowało fałszywe ogłoszenia, a przegląd trendów MyPerfectResume wskazuje dodatkowo szerokie stosowanie automatyzacji w procesach publikacji i selekcji.

Motywy publikowania „ghost jobs”

Po stronie legalnych pracodawców dominują motywacje wizerunkowo-operacyjne: chęć sprawiania wrażenia wzrostu i rozwoju firmy, utrzymywanie „otwartych drzwi” dla talentów, budowanie puli CV na przyszłość (talent pool) oraz testowanie rynku – od podaży kandydatów po oczekiwania płacowe. W przypadku oszustów stawka jest inna: fałszywe oferty służą phishingowi i kradzieży tożsamości, wyłudzeniom („opłata wstępna”, „sprzęt do pracy”) albo werbunkowi do nieuczciwych schematów.

zobacz raport od greenhouse (ENG) .pdf. 987 kB

SZTUCZNA INTELIGENCJA W REKRUTACJI – ALGORYTM, KTÓRY DECYDUJE O KARIERZE

Co to jest „screening” i jak działa?

Screening to wstępna preselekcja aplikacji: system (ATS/AI) parsuje CV i listy motywacyjne, zamienia je na dane, a następnie ocenia i porządkuje według ustalonych kryteriów. Może sprawdzać słowa kluczowe (np. nazwy technologii, certyfikaty), porównywać lata doświadczenia i zakres ról z opisem stanowiska, wykrywać braki (np. luki w zatrudnieniu) i dopasowanie formalne (lokalizacja, dostępność, uprawnienia), a także nadawać wynik (score) lub progi pass/fail.

„CV pod algorytm”: jak kandydaci oszukują screening (i dlaczego to szkodzi)

Kandydaci próbują czasem podbić wynik w systemie, upychając słowa kluczowe z ogłoszenia (np. wielokrotne powtórzenia nazw technologii), wstawiając ukryte frazy białą czcionką lub w metadanych PDF, kopiując opis stanowiska 1:1 do sekcji umiejętności, mnożąc synonimy, podkręcając tytuły ról, maskując luki formatem funkcjonalnym bez dat, tworząc „ścianę” nazw narzędzi bez kontekstu albo wklejając słowa kluczowe w grafiki. Tego typu triki zafałszowują obraz kandydata, wypychają uczciwe osoby z rynku pracy.

ALGORYTM, KTÓRY MIJA SIĘ ZE SPRAWIEDLIWOŚCIĄ

Przykład Amazona pokazał, jak łatwo AI może utrwalać uprzedzenia: testowy system do oceniania CV „nauczył się”, że preferowani są mężczyźni. Algorytm zaniżał oceny aplikacji kobiet (np. penalizował frazy typu „women’s…”, a nawet absolwentki żeńskich uczelni), dlatego projekt porzucono po analizach wewnętrznych i publikacji Reutersa. Sprawa stała się symbolem ryzyka, że modele uczą się z historycznych, stronniczych danych i powielają te schematy na masową skalę.

Co na to prawo: AI Act i „wysokie ryzyko” w zatrudnieniu

Unijny AI Act kwalifikuje wykorzystanie AI w obszarze zatrudnienia (np. rekrutacja, selekcja) jako „wysokiego ryzyka” i nakłada na firmy konkretne obowiązki: systematyczne zarządzanie ryzykiem, zapewnienie jakości danych, przejrzystość działania oraz nadzór człowieka nad decyzjami algorytmu.

ŹRÓDŁA

Sfinansowano przez Unię Europejską. Przedstawione poglądy i opinie wyrażają wyłącznie autor(ów) i nie muszą odzwierciedlać stanowiska Unii Europejskiej ani Europejskiej Agencji Wykonawczej ds. Edukacji i Kultury (EACEA). Ani Unia Europejska, ani EACEA nie ponoszą odpowiedzialności za te treści.

Young people’s challenges in recruitment – fake job ads and artificial intelligence

This article draws on insights from the SAGE – Social and Green Entrepreneurship network for youth initiative.

INTRODUCTION

This article looks at two key barriers that young people face at the start of their careers: fake job advertisements and AI-driven recruitment. The text is based on discussions held within the SAGE – Social and Green Entrepreneurship network for youth.

Within SAGE we ran short, interactive workshops with ten young participants. It was an open discussion format: people shared concrete stories from the labour market and jointly mapped the most difficult parts of the recruitment journey. The most frequent themes were: lack of experience when employers expect a lot, financial barriers, language-cultural barriers (especially for people with migration experience) and a lack of practical labour-market education.

The strongest common thread proved to be the moment of “getting stuck” right after sending an application: many participants received no response at all from employers. This silence creates frustration, a sense of powerlessness and demotivation, effectively blocking further steps. This experience is our starting point for exploring why fake ads exist and how artificial intelligence shapes selection.

FAKE JOB ADS – A HIDDEN TRAP OF THE LABOUR MARKET

The scale of fake postings

“Ghost jobs” — ads posted with no real intention to hire — are no longer marginal. Operational data from the Greenhouse platform show that every quarter 18–22% of all listings on their system qualify as ghost postings.

Self-reported surveys reveal the practice on the employer/recruiter side: in a ResumeBuilder poll about 40% of companies admitted posting a fake listing in the last year, while the MyPerfectResume trends review additionally points to extensive automation in posting and screening processes.

Why employers publish “ghost jobs”

For legitimate employers the motives are mostly brand/operational: signalling company growth, keeping “open doors” for talent, building a CV pool for future vacancies, and testing the market — from candidate supply to salary expectations. For scammers the goal is different: fake ads enable phishing and identity theft, advance-fee and “work equipment” scams, or recruitment into dubious schemes.

see the report by greenhouse (ENG) .pdf. 987 kB

ARTIFICIAL INTELLIGENCE IN RECRUITMENT – THE ALGORITHM THAT CAN SHAPE YOUR CAREER

What is “screening” and how does it work?

Screening is the initial pre-selection of applications: an ATS/AI system parses CVs and cover letters, converts them into data, and then scores and ranks them against predefined criteria. It can check keywords (technologies, certificates), compare years of experience and roles with the job description, detect gaps and formal fit (location, availability, authorisations), and assign a score or pass/fail thresholds.

“CV for the algorithm”: how candidates try to game screening (and why it backfires)

Some candidates attempt to boost their score by stuffing keywords from the ad (e.g., repeating technology names), inserting hidden phrases in white text or PDF metadata, pasting the job description 1:1 into a skills section, multiplying synonyms, inflating job titles, masking gaps with a functional format without dates, building “walls” of tools without context, or hiding keywords inside images. These tricks distort the picture of a candidate and push honest applicants out of the market.

AN ALGORITHM AT ODDS WITH FAIRNESS

Amazon’s example showed how easily AI can reinforce bias: an experimental CV-scoring tool “learned” to prefer men. The algorithm downgraded women’s applications (penalising terms like “women’s…”, even graduates of women’s colleges), so the project was dropped after internal analyses and press coverage. The case became a symbol of the risk that models learn from historical, biased data and reproduce those patterns at scale.

What the law says: the AI Act and “high-risk” in employment

The EU AI Act classifies the use of AI in employment (recruitment and selection) as “high-risk” and places specific obligations on companies: systematic risk management, data-quality assurance, transparency, and human oversight of algorithmic decisions.

SOURCES

Funded by the European Union. Views and opinions expressed are however those of the author(s) only and do not necessarily reflect those of the European Union or the European Education and Culture Executive Agency (EACEA). Neither the European Union nor EACEA can be held responsible for them.